idNSA.id - Sistem kecerdasan

buatan (AI) dapat dengan sengaja ditipu atau bahkan "diracuni" oleh

penyerang, yang menyebabkan malfungsi parah dan kegagalan yang mencolok.

Saat ini, tidak ada metode

sempurna untuk melindungi AI dari penyesatan, sebagian karena kumpulan data

yang diperlukan untuk melatih AI terlalu besar bagi manusia untuk dipantau dan

difilter secara efektif.

Ilmuwan komputer di National

Institute of Standards and Technology (NIST) dan kolaborator mereka telah

mengidentifikasi ini dan kerentanan AI lainnya serta langkah-langkah mitigasi

yang menargetkan sistem AI.

Laporan baru ini menguraikan

jenis serangan yang dapat dihadapi solusi AI-nya dan strategi mitigasi yang menyertainya

untuk mendukung komunitas pengembang.

Empat Jenis Serangan Utama

Penelitian ini melihat empat jenis serangan utama seperti:

Penghindaran

Keracunan

Privasi

Serangan Penyalahgunaan

Ini juga mengklasifikasikan mereka berdasarkan berbagai

karakteristik, termasuk tujuan dan sasaran, kemampuan, dan pengetahuan

penyerang.

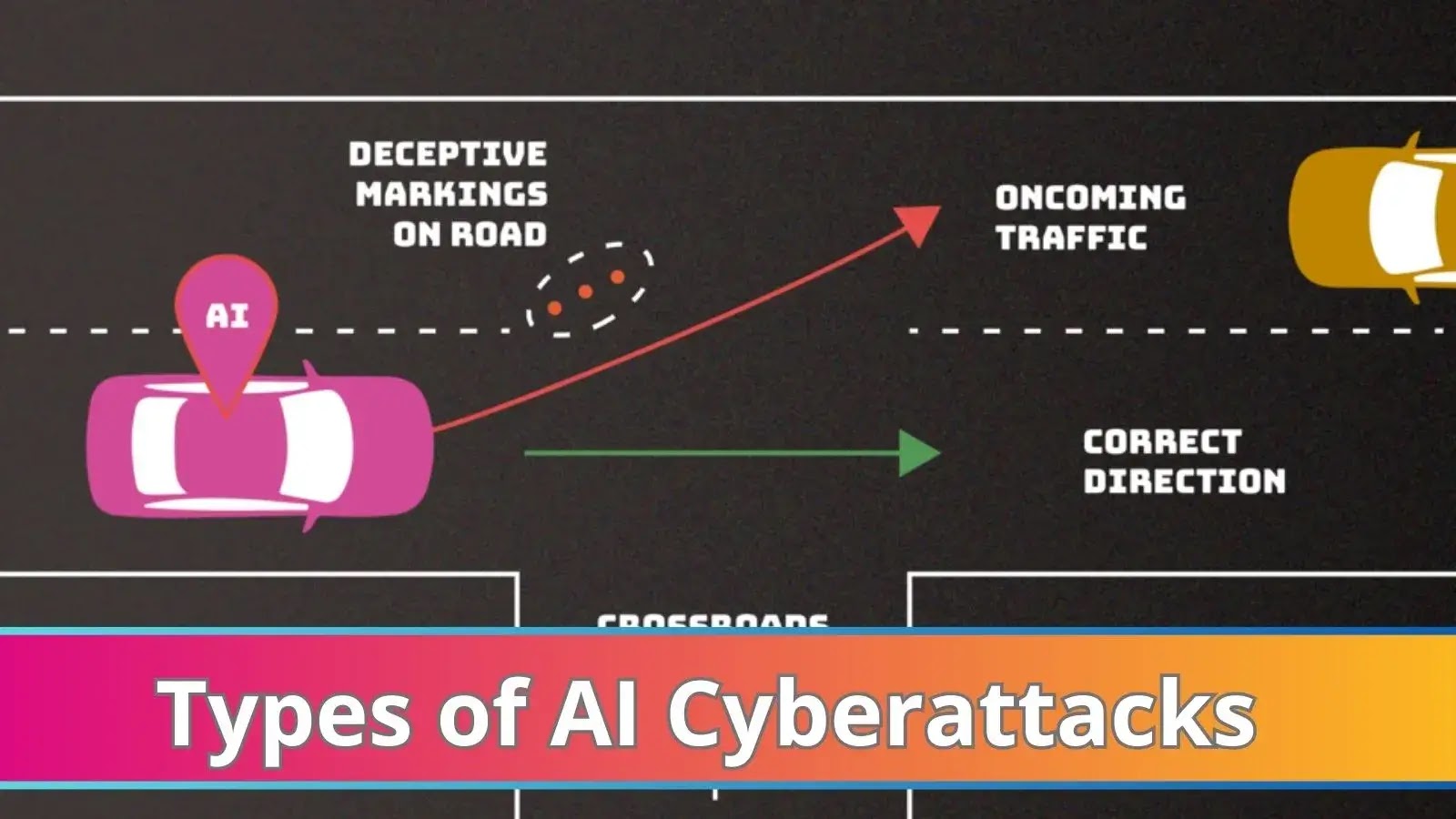

Serangan Penghindaran

Penyerang yang menggunakan teknik penghindaran mencoba

memodifikasi input untuk memengaruhi bagaimana sistem AI bereaksi terhadapnya

setelah penyebaran.

Beberapa contoh akan membuat marka jalur yang membingungkan

untuk menyebabkan mobil otonom membelok dari jalan atau menambahkan marka untuk

menghentikan rambu agar keliru dibaca sebagai rambu batas kecepatan.

Serangan keracunan

Dengan menyuntikkan data yang rusak selama proses pelatihan,

serangan keracunan terjadi. Menambahkan beberapa contoh bahasa yang tidak

pantas ke catatan percakapan, misalnya, bisa menjadi salah satu cara untuk

mengelabui chatbot agar berpikir bahwa bahasa tersebut cukup lazim untuk

digunakan dalam interaksi pelanggan nyata.

Serangan Privasi

Serangan terhadap privasi selama penyebaran adalah upaya

untuk mendapatkan informasi pribadi tentang AI atau data yang dilatih untuk

menyalahgunakannya.

Musuh dapat mengajukan banyak pertanyaan yang valid ke

chatbot dan kemudian memanfaatkan respons untuk merekayasa balik model untuk

mengidentifikasi kerentanannya atau berspekulasi dari mana asalnya.

Mungkin sulit untuk membuat AI melupakan contoh-contoh

tertentu yang tidak diinginkan setelah fakta, dan menambahkan contoh yang tidak

diinginkan ke sumber-sumber internet tersebut dapat menyebabkan AI berkinerja

buruk.

Serangan Penyalahgunaan

Dalam serangan penyalahgunaan, data yang salah dimasukkan ke

dalam sumber — halaman web atau dokumen online, misalnya — yang diterima AI.

Serangan penyalahgunaan bertujuan untuk memberikan AI informasi palsu dari

sumber yang sebenarnya tetapi rusak untuk menggunakan kembali sistem AI untuk

tujuan yang dimaksudkan.

Dengan sedikit atau tanpa pengetahuan sebelumnya tentang

sistem AI dan kemampuan permusuhan yang terbatas, sebagian besar serangan

relatif mudah diluncurkan.

"Kesadaran akan keterbatasan ini penting bagi

pengembang dan organisasi yang ingin menyebarkan dan menggunakan teknologi

AI," kata ilmuwan komputer NIST Apostol Vassilev, salah satu penulis

publikasi.

"Terlepas dari kemajuan signifikan yang telah dibuat AI

dan pembelajaran mesin, teknologi ini rentan terhadap serangan yang dapat

menyebabkan kegagalan spektakuler dengan konsekuensi yang mengerikan. Ada

masalah teoritis dengan mengamankan algoritma AI yang belum terpecahkan. Jika

ada yang mengatakan berbeda, mereka menjual minyak ular."